Как скрыть часть контента на страницах сайта от роботов поисковых систем?

Для каких целей следует скрывать содержание?

Разберемся с вопросами далее.

Зачем скрывать контент сайта от индексации?

Контент на сайте скрывается от поисковых систем для достижения различных целей.

Если скрыть часть контента от поискового краулера, то алгоритмы ранжирования обработают не всю страницу, а лишь ее часть. В результате поисковый оптимизатор может извлечь выгоду.

Если от поисковых систем часть сайта скрывается, то для пользователей весь контент остается полностью видимым.

Итак, какой контент имеет смысл скрывать и зачем? Например:

- Ссылки для улучшения внутренней перелинковки на сайте. Улучшение достигается за счет оптимизации распределения статического ссылочного веса на сайте;

- Часть текста для повышения релевантности страницы;

- Часть страницы для улучшения ранжирования. Например, скрытие рекламных блоков со страницы, которые находятся в верхней части страницы. Если такие рекламные блоки не скрывать, то поисковая система после рендеринга на так называемом первом экране распознает нерелевантный контент, что не позволит сайту ранжироваться лучше;

- Часть страницы для защиты от санкций поисковых систем. Например, часто требуется скрывать исходящие ссылки на различные сайты.

Есть еще множество различных ситуаций при которых требуется скрывать от поисковых систем часть страницы.

Например, поисковые системы пессимизируют сайты с реферальными ссылками. Такие сайты зарабатывают на партнерских отчислениях. С точки поисковых систем таких как Google подобные сайты не несут никакой дополнительной ценности для пользователя, а значит и не должны находиться среди лидеров поиска.

Если реферальные ссылки скрыть, проблем не будет.

Как скрыть от поисковых систем часть страницы?

На практике скрыть контент сайта от индексации можно используя разные способы.

Наиболее распространенным способом по скрытию текста от поисковых систем является использование подгрузки текста по параметру в хеш-ссылке. Исходя из заявлений Google, протокол HTTP/HTTPS не был разработан для такого использования, поэтому при использовании данного метода индексация не происходит.

Наиболее распространенным способом по скрытию ссылки от поисковых систем является использование контейнера div при создании ссылки.

Но что делать, если речь идет о создании системы для скрытия контента?

Какую технологию использовать? Основные требования следующие:

- У пользователя на экране должен отображаться весь контент страницы сайта;

- Для поисковой системы должен отдаваться не весь контент страницы сайта;

- Способ должен быть условно белым, чтобы сложнее было найти повод для санкций.

В результате оптимальной технологией является та технология, которая официально:

- Не поддерживается движком поисковой системы;

- Поддерживается популярными браузерами.

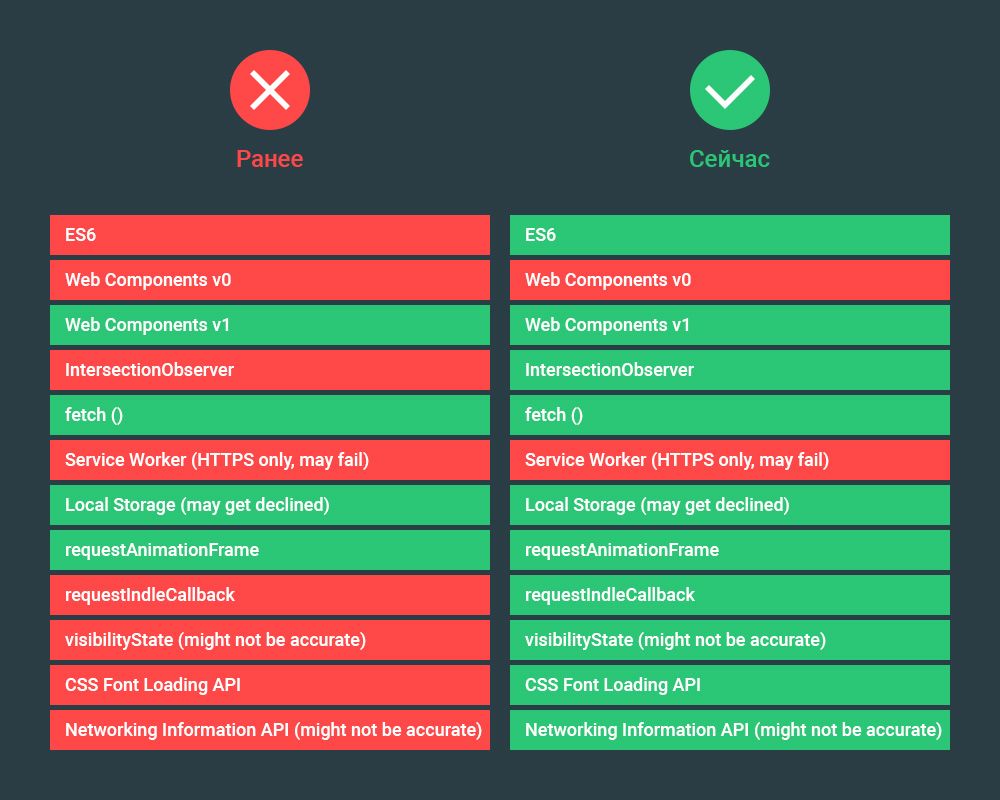

Ситуация ухудшается тем, что Google обновил поисковый краулер. Теперь Google выполняет скрипты, написанные на современном JavaScript.

Рекомендованный материал в блоге MegaIndex по теме обновления краулера по ссылке далее — Google обновил поисковый краулер. Что изменилось? Как это повлияет на ранжирование?

Все приведенные способы основаны на принципах работы поискового краулера.

Но лазейка все еще есть. В результате обновления стала известна информация о принципах работы поискового краулера, используя которую можно сделать выводы о том, какие именно технологии поисковый робот не поддерживает, а значит не передает в систему ранжирования.

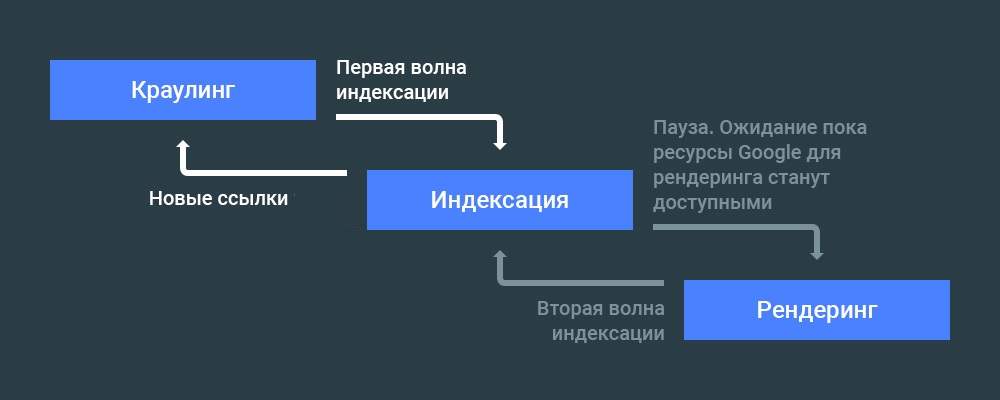

До начала этапа ранжирования происходит ряд процессов.

Весь процесс обработки информации до этапа ранжирования выглядит так:

После рендеринга происходит передача данных в систему ранжирования.

Если после рендеринга часть документа отсутствует, значит данная часть документа не будет участвовать и в ранжировании.

Теперь требуется разобраться с тем, какую технологию пока еще не поддерживает движок рендеринга. Применяя такую технологию на практике можно скрывать часть содержания страниц сайта от поисковой системы.

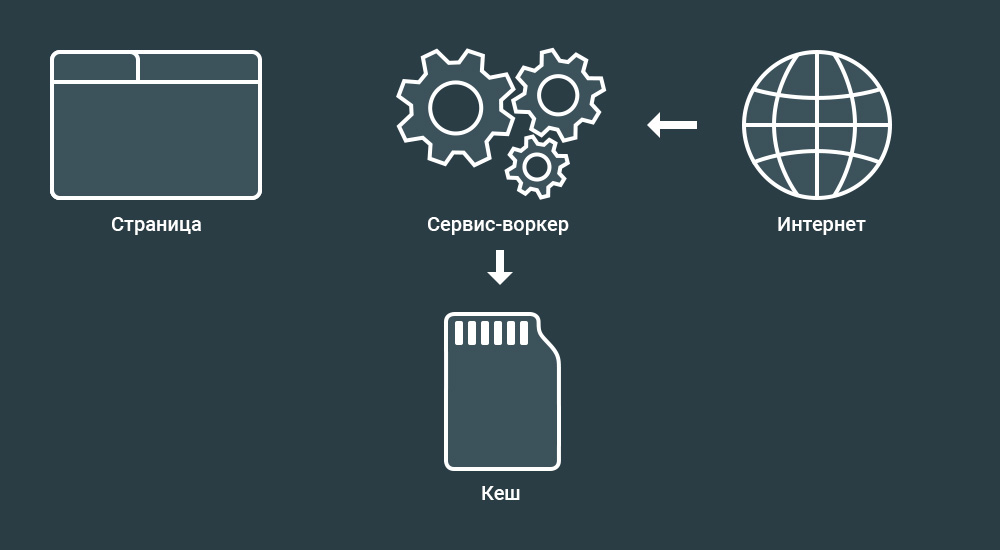

Итак, скрыть любую часть страницы от поисковой системы можно используя так называемые service workers.

Что такое сервис-воркеры? Сервис-воркеры — это событийный управляемый веб-воркер, регистрируемый на уровне источника и пути. Сервис-воркер может контролировать сайт, с которым ассоциируется, перехватывать и модифицировать запросы навигации и ресурсов.

Да, я вижу ваши лица. Подождите пугаться.

Если упростить, то сервис-воркером является программируемый сетевой проксификатор.

Иными словами, применяя сервис-воркер можно контролировать контент, который передаются пользователю.

В результате применения сервис-воркеров контент может изменяться. Поисковая система же обрабатывает такие корректировки, так как не поддерживает выполнения таких скриптов.

Почему метод эффективен в применении на практике? Сервис-воркеры поддерживаются всеми популярными браузерами и не поддерживаются движком рендеринга поисковой системы Google, через который данные передаются в систему ранжирования.

Следующие браузеры поддерживают сервис-воркеры:

- Chrome;

- Android Chrome;

- Opera;

- Safari;

- iOS Safari;

- Edge;

- Firefox.

Задача поискового оптимизатора заключается в следующем:

- Найти элементы, которые требуется скрыть от поисковой системы;

- Если такие элементы есть, то передать задачу в отдел разработки и оповестить про способы реализации на практике;

- Протестировать работу на примере одного документа путем использования программного решения Chrome Dev Tools или путем анализа кеша страницы в Google после индексации.

Вопросы и ответы

Есть ли официальные заявления о том, что Google действительно не поддерживает сервис-воркеры

Да, такие заявление являются публичными и есть на видео.

Зачем нужны сервис-воркеры?

На сайтах серивс-воркеры используют для разных целей. Например, для адаптации сайта под ситуацию с прерванным доступом к интернету.

Если интернет пропал, то при использовании сервис-воркеров сайты могут вести себя как приложения на мобильных устройствах, то есть отдавать уже скачанный контент и сигнализировать о необходимости подключения.

На практике сервис-воркеры используются еще и для кеширования изображений.

Еще используя сервис-воркеры можно сохранять данные заполненных форм и отправлять их в интернет при появлении подключения. Для реализации используется Background Sync API. Цепь следующая:

Сайт - Index DB - Service Worker - Интернет

Еще сервис-воркеры вместе с Content-Length и Range можно использовать для загрузки больших файлов частями. Например, так можно защищать видео от копирования.

Еще сервис-воркеры используются для отправки push уведомлений.

Кстати, сервис-воркеры продолжают работать даже когда окно браузера закрыто.

Кто использует сервис-воркеры?

Например сервис-воркеры используются на таких сайтах как:

- Google;

- YouTube;

- Twitter;

- Booking;

- Facebook;

- Washington Post;

Как скрыть весь сайт от поисковых систем?

В редких случаях сайты полностью могут быть закрыты от поисковых роботов. Например так защищают площадки от Роскомнадзора при продвижении сайтов различных спортивных тематик. Если стоит задача скрыть всю страницу или весь сайт от конкретных роботов, то наиболее эффективный способ заключается в запрете индексации на уровне сервера. Рекомендованный материал в блоге MegaIndex по теме защиты сайта от парсинга различными роботами по ссылке далее — Эффективные способы защиты от парсинга сайта.

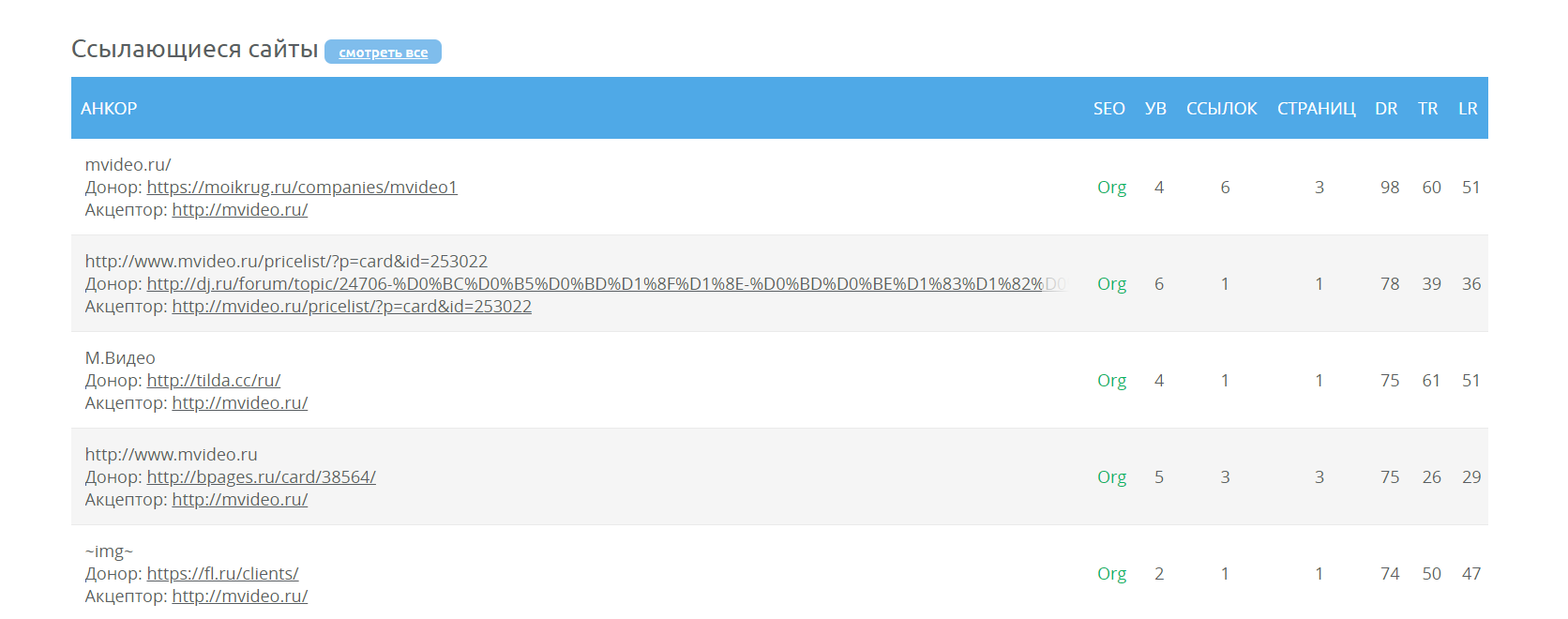

Кстати, краулер MegaIndex индексирует больше ссылок за счет того, что для робота MegaIndex доступ к сайтам не закрыт.

Почему так происходит? Поисковые оптимизаторы используют различные плагины для того, чтобы закрыть ссылки от таких сервисов как SEMrush, Majestic, Ahrefs. В таких плагинах используются черные списки. Если вести речь про глобальный рынок, то MegaIndex является менее расхожим сервисом, и поэтому часто краулер MegaIndex не входит в черный список. Как результат, применяя сервис MegaIndex у поисковых оптимизаторов есть возможность найти те ссылки, которые не находят другие сервисы.

Ссылка на сервис — Внешние ссылки.

Еще выгрузку ссылок можно провести посредством API. Полный список методов доступен по ссылке — MegaIndex API. Метод для выгрузки внешних ссылок называется backlinks. Ссылка на описание метода — метод backlinks.

Пример запроса для сайта indexoid.com:

http://api.megaindex.com/backlinks?key={ключ}&domain=indexoid.com&link_per_domain=1&offset=0Пример запроса для сайта smmnews.com:

http://api.megaindex.com/backlinks?key={ключ}&domain=smmnews.com&link_per_domain=1&offset=0Выводы

С обновлением Googlebot скрыть ссылки, текст и другие части страниц сайта от поисковой системы стало сложнее, но лазейки есть. Поисковый движок рендеринга по прежнему не поддерживает сервис-воркеры.

Используя service workers с запросами можно проводить следующие манипуляции:

- Отправлять;

- Принимать.

- Модифицировать.

Применяя сервис-воркеры можно скрыть от поисковых систем ссылки, текст, и даже блок страницы.

Итак, в результате при необходимости поисковый оптимизатор может:

- Закрыть от индексации внешние ссылки с целью улучшения распределения статического ссылочного веса;

- Закрыть от индексации страницы тегов с низкой частотностью;

- Закрыть от индексации страницы пагинации;

- Скрытый текст или часть текста от индексации;

- Закрыть от индексации файлы;

- Закрыть от индексации блок и часть страницы;

- Скрыть от индексации реферальные ссылки.

Сервис-воркеры можно использовать и в целях улучшения производительности сайта. Например, намедни Google стал использовать сервис-воркеры в поисковой выдаче.

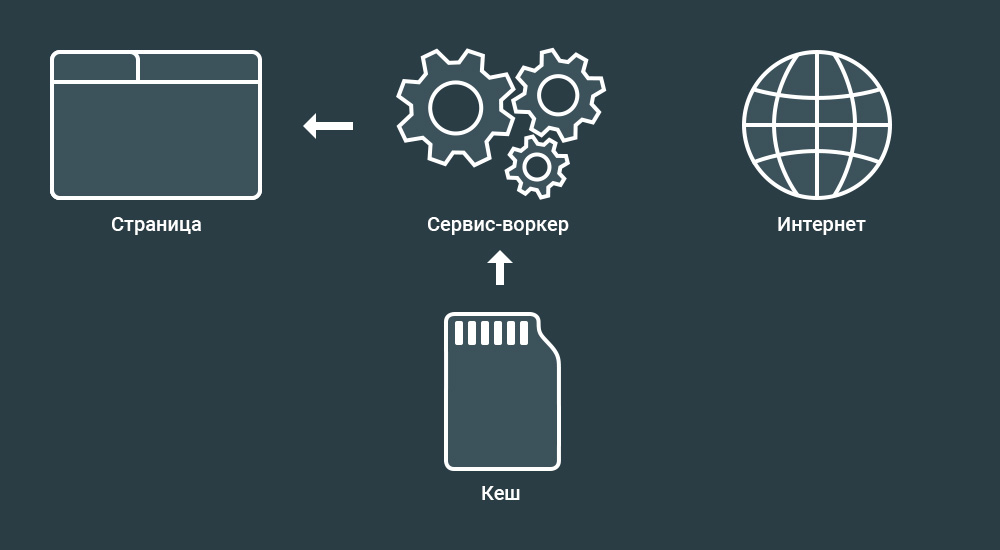

Схема одного из интересных трюков выглядит так:

- Вы искали ресторан, например утром;

- Спустя время, вы снова искали ресторан, например по той причине, что забыли о том, где находится заведение. На данном шаге Google выдаст результаты из кеша, который управляется сервис-воркером. Как результат, данные выдаются без отправки запроса в интернет.

Преимущества следующие:

- Снижается нагрузка на сервер Google, что приводит к снижению затрат;

- Увеличивается скорость загрузки страницы с ответом. Повышается лояльность пользователя;

- Страницы откроется даже без интернета. Повышается лояльность пользователя.

Остались ли у вас вопросы, замечания или комментарии по теме скрытия части содержания страниц от поисковых систем?

Обсуждение

Спасибо

Передать в отдел разработки - так себе совет для человека с маленьким блогом, который он ведёт один.

А вот это меня добило

"Если упростить, то сервис-воркером является программируемый сетевой проксификатор."

Упростил как бог

- использование подгрузки текста по параметру в хеш-ссылке;

- использование контейнера div при создании ссылки.

Ну и, как уже выше написали - покажите примеры реализации service worker.