Как правильно работать с картой сайта в 2020?

Рассмотрим практики по sitemap.xml, которые стоит применять на практике.

Разберемся с темой далее.

Карта сайта в 2020: практики, которые приносят результат

Практика №1. Трюк с использованием динамической sitemap.xml для индексации большого количества страниц сайта.

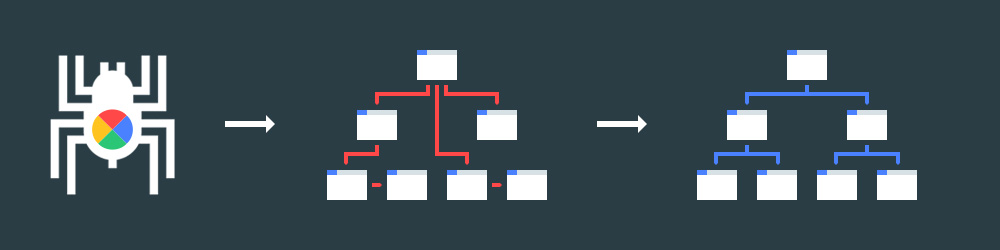

Смысл подхода заключается в автоматическом обновлении списка страниц в файле карты после посещения поисковым краулером страниц из sitemap.xml.

Схема такая:

- Карта sitemap.xml составляется из списка страниц, которые не попали в индекс поисковой системы;

- Краулер поисковой системы посещает карту сайта и индексирует объем страниц согласно краулинговому бюджету;

- Посещение краулера фиксируется в логах сервера;

- Из карты сайта удаляются адреса страниц, на которые зашел краулер поисковой системы;

- В карту добавляются следующий набор страниц подлежащих индексации.

Процесс поддается автоматизации.

Рекомендованный материал в блоге MegaIndex на тему краулингового бюджета по ссылке — Краулинговый бюджет сайта — что это и как его оптимизировать?

Такой трюк решает проблему с индексацией для агрегаторов, на которых размещается большое количество страниц. Пример агрегатора — 2yachts. На сайте большой объем страниц, постоянно происходит ротация страниц. Яхты добавляются и удаляются. Есть проблема с индексацией страниц. Решение проблемы описано выше.

Данный способ подходит для всех сайтов. Применяйте данный способ на практике. В результате проблему с индексацией страниц сайта можно решить.

Практика №2. Скрытие карты сайта в целях защиты от парсинга.

Если на сайте появляются новые страницы с уникальным и ценным контентом, карту сайта следует скрыть от третьих лиц.

Зачем? Технологии и инструменты для парсинга контента стали дешевыми. Парсеры сторонних проектов могут скопировать новый контент в автоматическом режиме, затем опубликовать на стороннем ресурсе и проиндексировать. Как результат, авторство закрепляется за сторонним сайтом, а оригинальные страницы теряют потенциал в поисковой выдаче.

Как скрыть карту? Шаги простые:

- Следует использовать альтернативный путь к карте сайта. Стандартный путь следующий — [адрес сайта]/sitemap.xml;

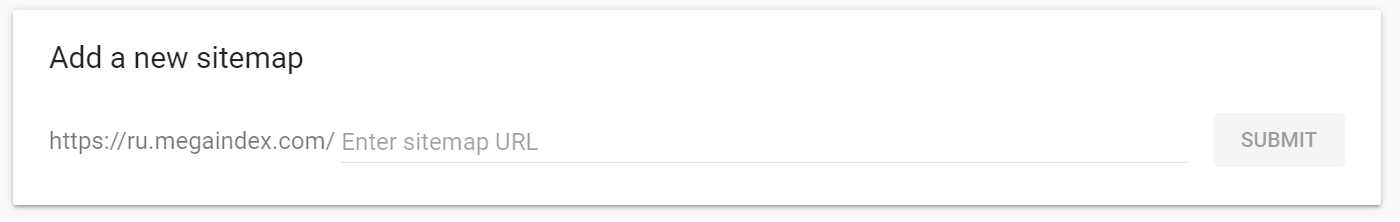

- Для поисковых систем указать ссылку на карту сайта через инструменты Google Search Console и Yandex Webmaster.

Допускается любой адрес к файлу и любое название файла карты сайта:

Как направить карту в поисковую систему на индексацию без подтверждения прав на сайт? Есть вариант использовать специальный инструмент ping. Просто подставьте адрес карты в шаблон ссылки и перейдите по ссылке.

https://www.google.com/ping?sitemap=[полный адрес карты сайта]

Пример для indexoid.com.

https://www.google.com/ping?sitemap=https://indexoid.com/sitemaps.xml

Практика №3.Создайте карту сайта для изображений, видео и новостей. Индексация страницы не означает индексацию изображений. Любой файл изображения является отдельным документом от страницы. Специальная карта сайта решит проблему с индексацией изображений на сайте.

Для изображений следует использовать специальный формат карты сайта.

Пример разметки:

<?xml version ="1.0" encoding="UTF-8"?> <urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9" xmlns:image="http://www.google.com/schemas/sitemap-image/1.1"> <url> <loc>http://example.com/primer.html</loc> <image:image> <image:loc>http://example.com/kartinka.jpg</image:loc> </image:image> <image:image> <image:loc>http://example.com/photo.jpg</image:loc> </image:image> </url> </urlset>

Поисковые оптимизаторы очень редко создают sitemap для изображений. Но направление по раскрутке картинок является перспективным. Начинать следует с автоматизации процесса индексации.

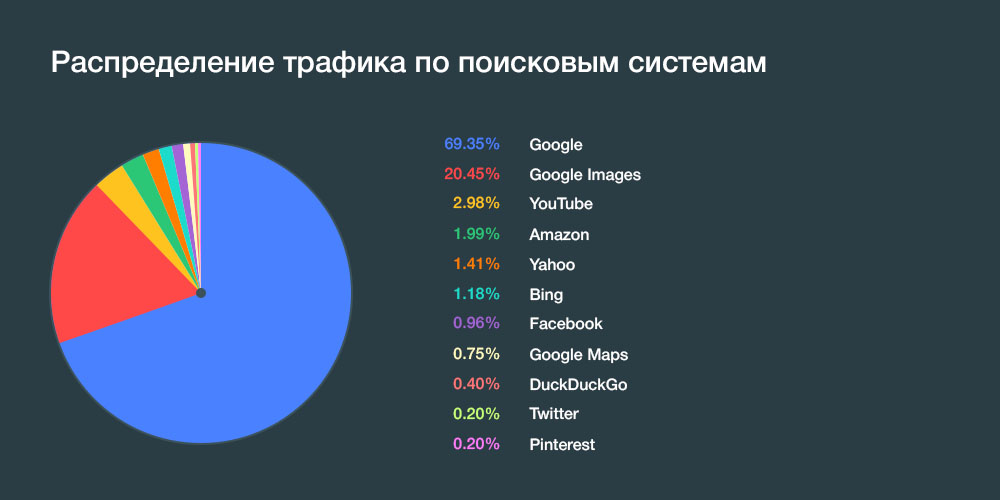

Почему это важно? Доля трафика поисковой системы Google Images в мире превышает отметку 20%. Для вебов поисковая система по картинкам является значимым источником трафика.

Рейтинг популярности поисковых систем в мире:

Рекомендованные материалы в блоге MegaIndex на тему раскрутки изображений по ссылкам далее:

- Появился новый атрибут тега img, который позволяет ускорить загрузку сайта. Пример реализации;

- Google изменит дизайн выдачи в поиске по картинкам и внедрит разметку licensable;

- SEO оптимизация изображений — Как получать трафик за счет SEO оптимизации изображений.

Если на сайте есть новости, то сайт следует добавить в Google News и создать специальную sitemap для новостей.

Пример разметки:

<?xml version="1.0" encoding="UTF-8"?> <urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9" xmlns:news="http://www.google.com/schemas/sitemap-news/0.9"> <url> <loc>http://www.example.org/business/article55.html</loc> <news:news> <news:publication> <news:name>The Example Times</news:name> <news:language>en</news:language> </news:publication> <news:publication_date>2008-12-23</news:publication_date> <news:title>Companies A, B in Merger Talks</news:title> </news:news> </url> </urlset>

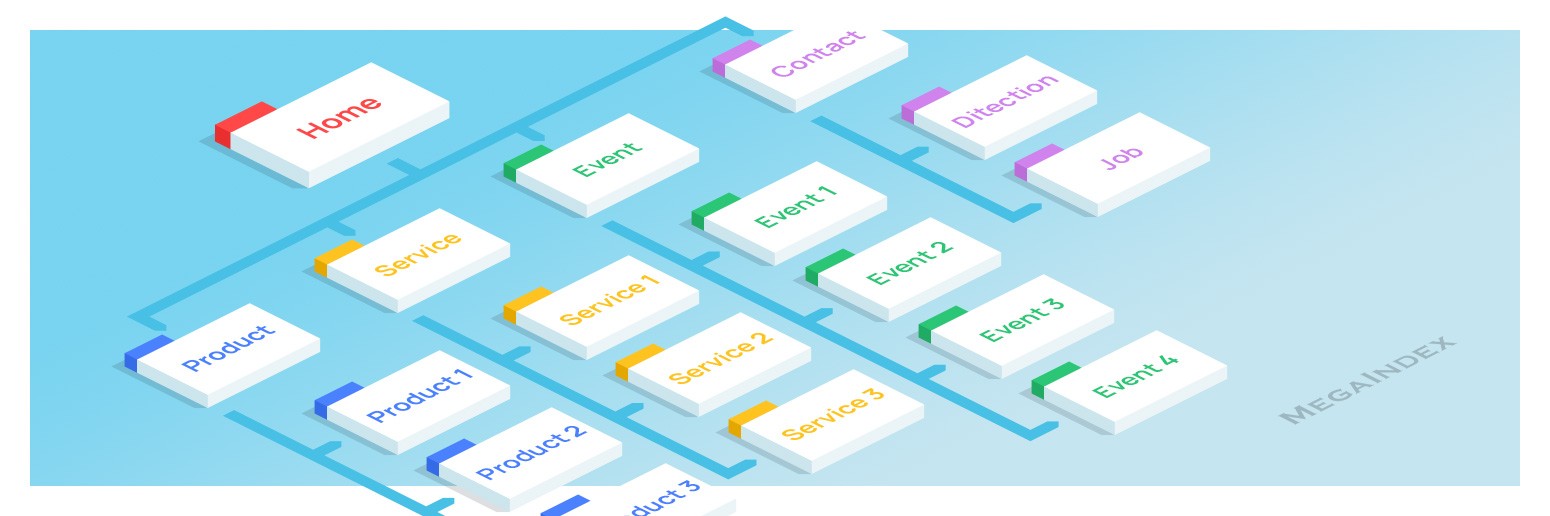

Выше расписаны практики, которые позволяет наладить индексацию. Какие есть технические требования к карте сайта?

Технические требования

Какие ограничения установлены для файла sitemap? Максимальное количество страниц в карте сайта не должно превышать 50 000 ссылок, а максимальный допустимый размер файла не должен превышать 50 мегабайт.

Если страниц больше — не проблема.

Решения:

- Поисковые системы способны обрабатывать карты сайта в формате архива;

- Допускается создание 500 sitemap для одного сайта. Решение проблемы заключается в разгруппировке большой карты сайта на более мелкие.

Если файлов sitemap множество, то следует создать файл с индексом карт сайта, так называемый sitemapindex.

Пример разметки:

<?xml version="1.0" encoding="UTF-8"?> <sitemapindex xmlns="http://www.sitemaps.org/schemas/sitemap/0.9"> <sitemap> <loc>https://site.com/sitemap1.xml.gz</loc> </sitemap> <sitemap> <loc>https://site.com/sitemap2.xml.gz</loc> </sitemap> </sitemapindex>

Как проиндексировать карту сайта без добавления сайта в инструменты Yandex, Google? Есть 2 решения:

- Использовать ping;

- Прописать полный путь к карте сайта в файле директив для краулера robots.

Как без ошибок прописать путь к sitemap в robots.txt? Путь задается через указатель Sitemap.

Пример:

Sitemap: https://seoheronews.com/sitemap.xml Sitemap: https://seoheronews.com/blog-sitemap.xml

В robots важны следующие нюансы:

- Директива Sitemap указывается с заглавной буквы S;

- Sitemap не зависит от инструкций User-Agent;

- Нельзя использовать относительный адрес карты сайта, только полный адрес к карте.

Как создать sitemap? Задача по автоматизации sitemap.xml относится к нише разработки сайта.

Есть сервисы для создания карт сайта, но такие сервисы не особо полезны на практике.

- xml-sitemaps.com

- web-site-map.com

- xmlsitemapgenerator.org

- freesitemapgenerator.com

- xsitemap.com

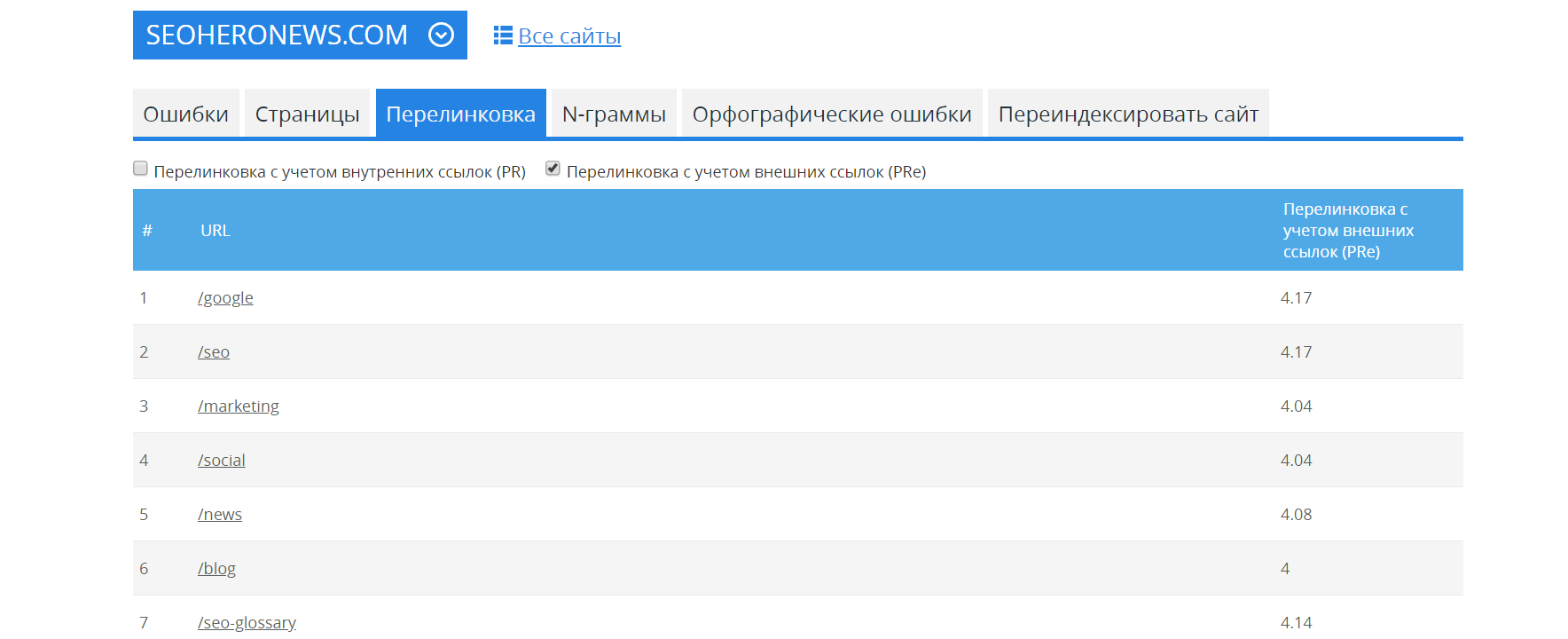

Кстати найти мелкие проблемы на сайте способен инструмент по аудиту сайтов от MegaIndex.

Ссылка на сервис — Аудит сайта.

Пример отчета для сайта seoheronews.com.

Выводы

Зачастую при продвижении карта сайта используется просто как файл со списком всех страниц сайта. Не более.

В основном на проектах данный файл является статическим. В таком случае sitemap не решает задачу по индексации всех страниц сайта ввиду ограничений краулингового бюджета.

Но потенциал применения карты сайта намного больше. Описанный выше трюк позволяет отладить и автоматизировать процесс индексации всех страниц для любых сайтов, включая крупные проекты на десятки тысяч страниц.

Рекомендованный материал в блоге MegaIndex на тему индексации страниц сайта по ссылке — Как быстро проиндексировать страницы чужих сайтов. И зачем?

Специальная карта сайта для изображений решает проблему с индексацией графики.

Данный способ эффективен для магазинов. Для примера, на практике с помощью карты изображений удалось проиндексировать все изображения, которые были размещены на сайте магазина по продаже ламината. На магазин стал приходить трафик из поиска по изображениям. Дополнительных действий по внешнему продвижению не проводилось.

Есть вопросы? Как вы используете карту сайту? Напишите в комментариях.

Обсуждение

1) по первому пункту - как определить "список страниц, которые не попали в индекс поисковой системы;"

Особенно если сайт большой от 100.000 страниц.

2) четвертый пункт "Из карты сайта удаляются адреса страниц, на которые зашел краулер поисковой системы;"

Но ведь посещение страницы потом не гарантирует ее попадание в индекс, как с этим быть.

3) по поводу индексации картинок тоже какая-то недосказанность

2 пункт - заведи табличку: Дата выгрузки в сайтмеп. и дата посещение ботом гугла

Еще не забудь проверить, что это реальный бот гугла. (ip revers dns)

2 пункт - вот делать человеку нечего, как 100к URL чекать в exel. Да и на вопрос нет ответа с Вашей стороны. А вопрос был задан такой (перефразировал специально, доступным языком): "Зачем из SM удалять URL, если бот зашел, чекнул, но в индекс может и не внести?" Ответ я дал выше.

По факту: смысла удалять проиндексированные URL из SM - нет. Бот по этим страницам совершает переобход время от времени, особенно если дата обновления в его БД указана старая, а в SM указано, что страница была обновлена "N" периодом позже. Да и мощности железа сегодня не такие уж и смехотворные, чтобы бот создавал при перепроверке страницы нагрузку.

Из полезного по статье:

1. Меняем название (или делаем нетипичным) самой SM, чтобы избежать парсинга.

2. Делим SM, если страниц овер "много".

2. Нормальная страница попадет в поисковую выдачу. Если страница размечена поисковой системой как спам, то в поисковую выдачу не попадет;

3. Конкретизируйте.

2) такая проблема у гугла бывает - простого решения нет - делаем перелинковку, улучшаем контент страниц

3) картинки - с ними работаем уже по остаточному принципу, когда все остальное сделано, видимо поэтому не стали писать подробно

Периодичность зависит от обновлений на сайте. Если контент добавляется часто, то и частота переобновдения карты выше. И наоборот.

Сайтмап для картинок - это отдельный файл? Или картинки прописываются в тотже сайтмап, где и страницы?

Если отдельный, то в robots.txt надо указывать оба??? Или надо делать sitemapindex?

Куча вопросов после прочтения.