Что изменилось в SEO? Какие работы на многих сайтах не выполнены? Коротко. Только о самом главном.

Тренд 1 — Оценка удобства использования сайта

Поисковые системы начали применять алгоритмы оценки удобства использования сайтов.

Оценка происходит через набор показателей Web Vitals.

Набор содержит в 8 метрик. 4 метрики обозначены как Core Web Vitals, то есть являются наиболее важными.

Основные метрики:

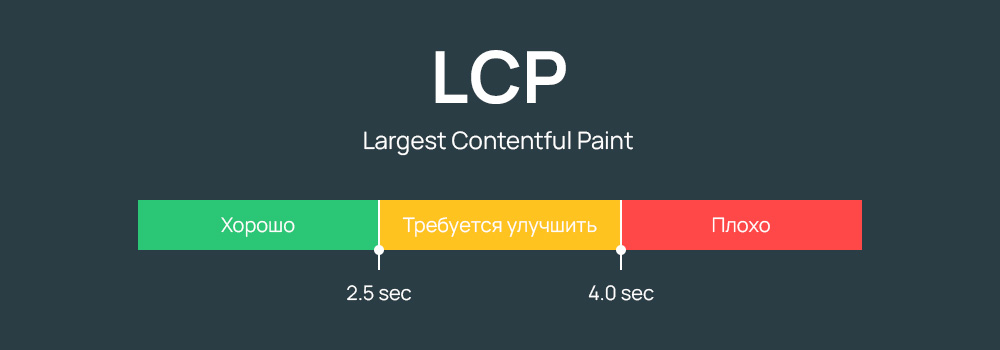

- Largest Contentful Paint — оценивается рендеринг наиболее значимого элемента на странице сайта;

- First Contentful Paint — оценивается производительность загрузки первого экрана страницы;

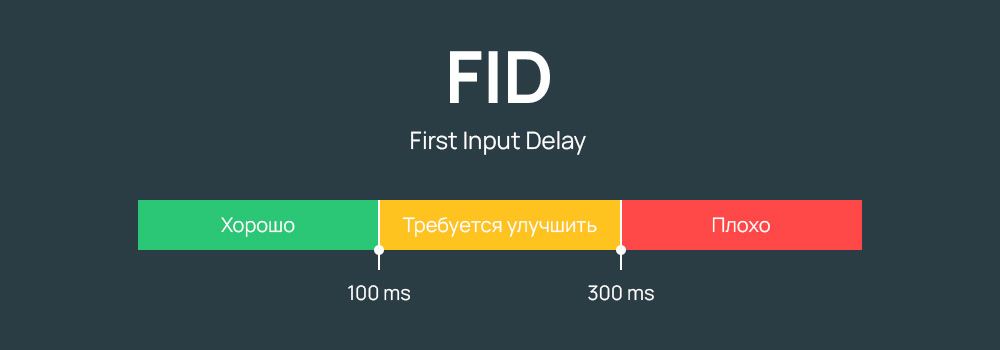

- First Input Delay — время блокирования до взаимодействия с сайтом. Оценивается интерактивность;

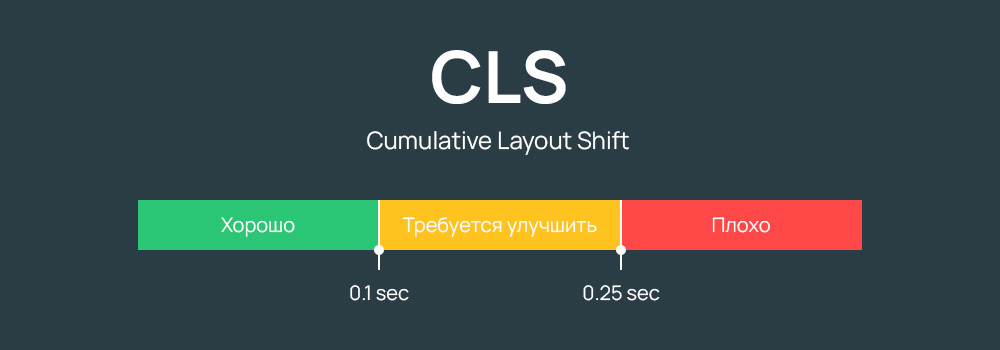

- Cumulative Layout Shift — оценивается визуальная стабильность верстки, а именно — сдвиг шаблона после загрузки страницы сайта.

Сервис для проверки основных метрик сайта — pagespeed.web.dev.

Фальшивое улучшение метрик неэффективно, потому при оценке выгружаются полевые данные, которые поисковая система собирает через браузер.

У каждой из метрик есть оптимальные значения.

Также в Web Vitals учитываются: адаптивность макета, безопасность просмотра и выполнение рекомендаций в отношении навязчивых межстраничных объявлений.

Можно создать отдельные материалы касательно улучшений по каждой из метрик. Напишите запрос в комментариях, если интересно.

Тренд 2 — Монополизация трафика

Поисковые системы отобрали у сайтов еще более значимую долю трафика из поисковой выдачи.

По аналитическим данным обычные сайты получают меньше 50% трафика из поисковой выдачи.

Что делать в условиях монополизации? Минимизировать зависимость бизнеса от поисковой системы.

Например:

- Развивать страницы на платформах, которые принадлежат поисковым системам;

- Заниматься брендом. Брендовые запросы являются навигационными. Поисковая система не показывает другие сайты в ответ на брендовые запросы;

- Создать приложение. Если модель бизнеса предполагает повторные продажи, надо создавать приложение. Нет денег на полноценную разработку — создать ботов в мессенджерах или использовать приложение на Progressive Web Application;

- Выстраивать систему внутренней аналитики и работать с привлеченной базой.

Сегментирование пользователей и использование персонализированных рассылок является эффективным способом повысить доходность.

Финансово успешные стартапы за каждым пользователем закрепляют персонального менеджера.

Тренд 3 — Проверка экспертизы, авторитетности и надежности источника контента

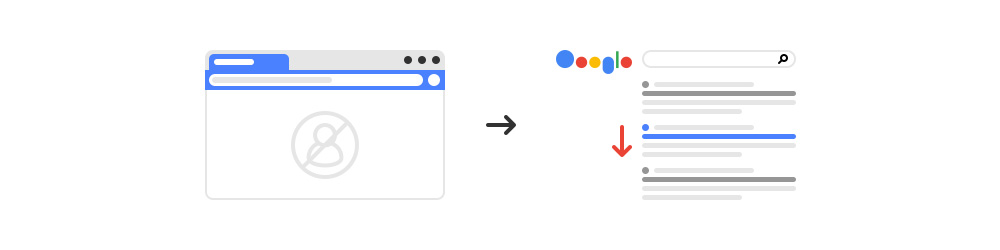

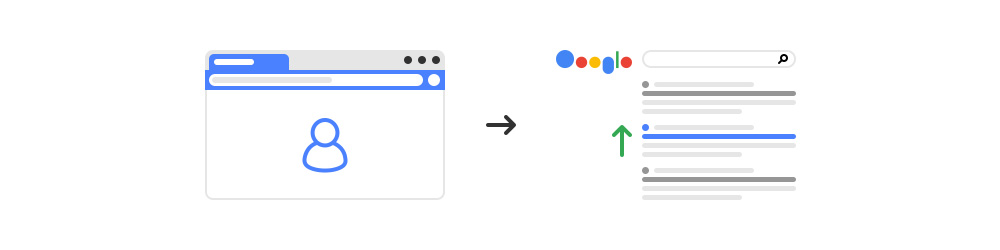

Поисковые системы внедрили алгоритм для проверки качества источника.

На страницах сайта рекомендуется указывать подлинных авторов контента.

Используйте на сайте специальную разметку Person чтобы обозначить полноценно автора.

Разметка для примера с сайта indexoid:

<script type="application/ld+json">

{

"@context": "https://schema.org/",

"@type": "Person",

"name": "Dmytro Ugnichenko",

"url": "https://indexoid.com",

"image": "https://indexoid.com/founder.jpg",

"sameAs": [

"https://www.facebook.com/dmytrx",

"http://twitter.com/ugnichenko",

"https://www.youtube.com/channel/UCnYE7CDNDYmIqVPxtRW_zUw"

],

"jobTitle": "Founder",

"worksFor": {

"@type": "Organization",

"name": "Indexoid.com"

}

}

</script>

На страницах компаний рекомендуется размещать информацию о команде, сертификаты.

Как минимум, размещение информации позволяет исключить учет фактора при флуктуациях в органической выдаче поисковой системы. Как максимум — рост позиций сайта.

4 — Дополнительные тренды в поисковой оптимизации

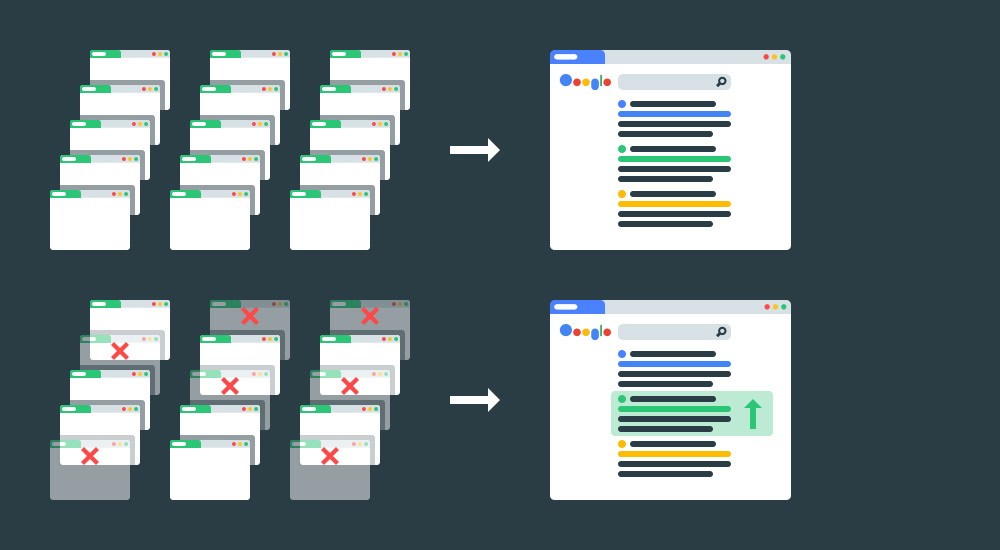

Удаление страниц низкого качества. Страницы низкого качества и без трафика следует удалять.

Index now. Яндекс и Bing внедрили механизм для быстрой индексации страниц. Смысл только в автоматизации. Страниц сайта и так можно индексировать через запрос на обход поисковым роботом.

Адаптация сайта под мобильные устройства. Перевод сайтов на Mobile-First Index продолжается. На практике мало сайтов адаптированы к мобильным устройствам.

Политика конфиденциальности. На сайтах рекомендуется создавать страницы такого плана как Политика конфиденциальности и подобные.

Конечно, данная страницы не повлияет напрямую на позиции в поисковой выдаче, но при ручной проверке сотрудники поисковой системы оценивают наличие страниц юридического характера.

Google разработал специальный сайт на тему о приватности данных — privacysandbox.com.

Просто надо создать страницы, чтобы исключить данный фактор.

Сайтам из европейского региона согласно требованиям GDPR надо создавать страницу "Согласие на обработку персональных данных для посетителей сайта".

Перечисленные выше задачи не отменяют алгоритмы используемые ранее.

Есть что добавить, ваше мнение? Напишите в комментариях.

Мнения экспертов

Дмитрий Севальнев:

- 90% оптимизаторов не оценивают отдачу от работ после внедрения. В реальности, от 70% работ можно отказаться, они НЕ ДАЮТ численного результата по росту трафика.

- Забывают оценивать качество распределения запросов и перегруппировку по итогам 6+ месяцев работы. Реальность такова, что многие группы могли распасться или наоборот — запросы пора продвигать на 1 странице, вместо нескольких.

- Расширять семантику. Собрали запросы 1 раз и начали добирать новые только через 2 года — типичная картина.

- Пересматривать бюджет на SEO исходя из показателя ROI (шаблон). Важно, чтобы бюджет на каждый канал был динамический и зависел от результатов и возврата инвестиций в него.

- Проверять на практике то, что говорят представители Яндекса и Google и SEO-эксперты. Многие популярные стратегии не работают, надо проводить собственные замеры и эксперименты. Это относится и к тому, что говорят делать представители поисковых систем (особенно — Google).

Илья Русаков:

Основные тренды, которые дадут толчок вашим проектам в 2022 году и которые специалисты упускают до сих пор

- Качество коммерческих сайтов.

- Новые обновления Яндекса — отзывы о сайте, отзывы о компании и другие факторы, по которым поисковик косвенно пытается понять и определить качество оказываемых услуг и качество работы компании. В Google всем знакомые EAT, YMYL. В этом направлении необходимо качественно улучшать свои коммерческие проекты

- Оптимизация под блоки ответов и оптимизация под другие "острова" поисковой выдачи.

- Необходимо работать над всей поисковой выдачей и привлекать трафик не только к себе на сайт, но и через площадки, которые занимают высокие места в ТОПе.

- Работа над брендовой выдачей.

- Пандемия накладывает свои отпечатки на процесс принятия решения пользователей, которые более щипитильно относятся к выбору компании, где заказать товар или услугу. Люди читают о бренде, узнают о бренде, изучают отзывы. Поэтому важно, чтобы в брендовой выдаче у пользователя сложилось только положительное впечатление о вас.

Миндубаев Рамазан (Head of SEO в интернет-агентстве TRINET.Group)

Актуальные тренды. По наблюдениям, что обычно оптимизаторы упускают (не учитывают изменения алгоритмов)?

- Алгоритмы поисковых систем развиваются Яндекс внедрил и улучшает Yati, Google переходит и улучшает Mum в связи с этим оптимизаторам необходимо перестроить свою оптимизацию с работой с ключевых слов на оптимизацию под поисковые векторы и тематическое окружение, а также на улучшение страниц с точки зрения экспертной оценки, так как это следующая задача которую стремится решить поиск. Цель: научиться ранжировать сайты, контенту которому больше оснований доверять.

- Специалистам по поисковому продвижению в связи со стремлениями поисковых систем дополнительно оценивать не только контент, но и бизнес который за ним стоит, предстоит помогать решать задачи вне сайтов, а именно анализ и управление репутацией, оценка бизнеса клиента со стороны потребителей. В иных ситуациях, возможны наложения санкций и отсутствие роста. Все больше сайт и бизнес стают неразрывным общим, а SEO-специалист трансформируется в поискового маркетолога, который работает над качеством продукта и его представлением.

- Часто наблюдаю ошибку, когда оптимизаторы упускают из зоны своего контроля формирование листингов, а именно какая информация туда выводится, как они формируются, когда они исчезают, а это напрямую влияет на поведенческие факторы, текстовую оптимизацию и как итог на результаты продвижения.

- Большинство не владеет информацией о том, каким образом поисковая система приходит на сайт, какие страницы изучают, какие коды ответов и контент получает поиск. Рекомендую изучать Log файлы, в них часто лежит множество ответов.

- В последнее время, Яндекс Справочник массово удаляет карточки организаций, либо просит предоставить документы и видео подтверждающие месторасположение офиса, необходимо пристально следить за этим, так как отсутствие геопривязки может сильно изменить позиции вашего сайта поо геозависимым запросам в негативную сторону.

- Часто для Google является проблемой большое количество “зомби” страниц, которые не приносят трафик и не имеют спроса, либо страницы, которые являются близкими конкурентами по семантической связи, в связи с этим могут быть проблемы с отсутствием высоких позиций, рекомендую обращать на это внимание и устранять проблемы. Часто оптимизаторы не любят закрывать страницы от индексации, руководствуясь правилом, что больше, значит лучше, но это не всегда является истиной.

Владислав Моргун

В поисковой системе существует несколько групп факторов, над которыми разработчики итерационно работают для улучшения результатов поиска, например, алгоритмы ссылок (сколько было запусков Пингвина и т.д.?), качество информации, поведенческие факторы, техническая оптимизация и так далее. Если мы изучим историю обновлений, то мы можем заметить определенные закономерности. Например, популярный в 2021 году Core Web Vitals — это усовершенствование SpeedUpdate (2017) и следствие изменений в front-end разработке. Поисковая система должна работать над LTV пользователей. Думаю, что разработчики поисковой системы и дальше будут работать над качеством контента.

Например, мы увидим большее влияние семантического поиска (граф знаний), а это означает, что специалисты по SEO должны больше разбираться в использовании Schema разметок. Больше будет апдейтов с использованием различных NLP подходов (в 2021 нам уже презентовали MUM).

Поскольку разработка не стоит на месте, то и основы JS становятся все важнее для SEO специалистов (минимум изучить материалы wed.dev и mozilla mdn). Это не новость, но многие специалисты в поисковой оптимизации до сих пор не взялись за самообучение.

К проверке E-A-T факторов будут привлекать все больше асессоров и к этим проверкам добавлять автоматизацию, например, как мы видели в Hot Fix для DecorMyEyes в 2010 году (да, кейс старый, но яркий для примера).

Кроме того, Google за последние пару лет столкнулся с огромным количеством спама и заметно то, что их текущие алгоритмы в таком потоке передачи статического веса не всегда могут отсеять спам, а потому им нужно будет что-то предпринять в ближайшем времени. Скорее всего они не могут просто так отсечь часть графа, поскольку это потянет за собой пересчет множества весов (затраты на вычислительную мощь), а потому либо будут новые алгоритмы по определению спама, либо алгоритмы для увеличения скорости обработки данных, но в любом случае Google должен будет решать данную проблему.

Андрей Буйлов:

Сила бизнеса и репутация будет влиять всё сильнее.

Работа с отзывами уже должна вестись полным ходом.

Аналог EAT в Яндексе уже в этом году покосил многих. Нужно и все e-commerce проекты приводить к соответствию этому. Прокачивать авторитет как авторов, так и проекта в целом.

Дропы уже не те. Реже восстанавливаются после периода недоступности, реже дают нужный эффект.

Накрутка ПФ уже не та. Стало менее предсказуемо, хоть и почти не накладываются теперь годовые санкции.

Традиционно будет больше колдунщиков на выдаче.

Будут ещё попытки лучшего понимания смысла документа и его частей.

Обсуждение

Спс за интересности, особенно про 50% )))

И в речи Владислав Моргун текст дублируется, я понимаю конечно Матрица вышла....