Как изменяются подходы к оптимизации индекса сайта?

Разберем важные нюансы об индексации сайтов поисковой системой, про которые мало кто знает.

Влияние индексации сайта на позиции в поисковой выдаче

Оптимизация индекса является отправной точкой в начале работ по продвижению любого сайта.

Большое количество мусора — проблема, поскольку удалить большое количество страниц из индекса крайне сложно.

Запрет в файле robots.txt решит проблему только для Яндекс. Для Google потребуется дополнительный переобход страниц, которые следует исключить из поисковой системы.

Нет инструментов по массовому удалению страниц из индекса Google. Официальный инструмент лишь скрывают страницы из поисковой выдачи.

Как индекс влияет на ранжирование? Влияние происходит так:

- Наличие большого количества страниц с thin content или бесполезным контентом воспринимается как попытка манипуляции;

- Через хостовые факторы сайта.

Практика показывает, что удаление из индекса страниц с бесполезным контентом положительно влияет на позиции сайта в поисковой выдаче.

Как происходит индексация сайтов?

Сначала разберемся с термином. Что такое индексация сайта? Индексация сайта — сканирование, сохранение страниц в базу поисковой системы и дальнейшая обработка алгоритмами.

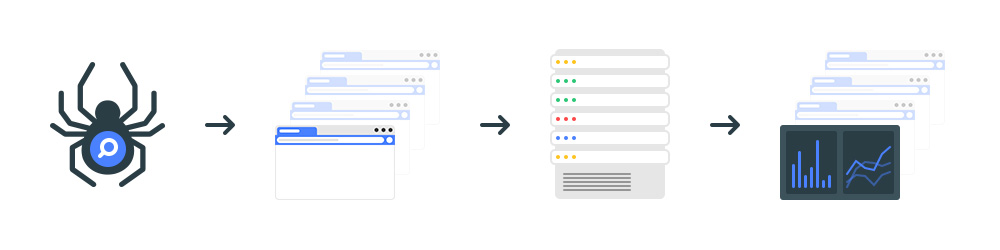

Процесс индексации сайта в упрощенном виде:

- Краулер поисковой системы сканирует сайт;

- Система индексации обрабатывает контент.

На практике схема индексации намного сложнее. Разберем как проходит процесс индексации на примере Google.

В процессе индексации участвует три отдельных системы: планировщик, робот для сканирования сайтов и система обработки.

Google Scheduler создает план на индексацию с учетом краулингового бюджета на сайт.

Googlebot сканирует сайты и сохраняет данные в бинарном виде.

Google Caffeine — система обработки проиндексированных страниц. Задача системы заключается в приеме, обработке и распределении страниц сайтов по индексам.

Каждую секунду Caffeine обрабатывает сотни тысяч страниц параллельно. Процесс индексации происходит постоянно. Индекс обновляется частями.

Что происходит внутри Caffeine?

Как работает Google Caffeine

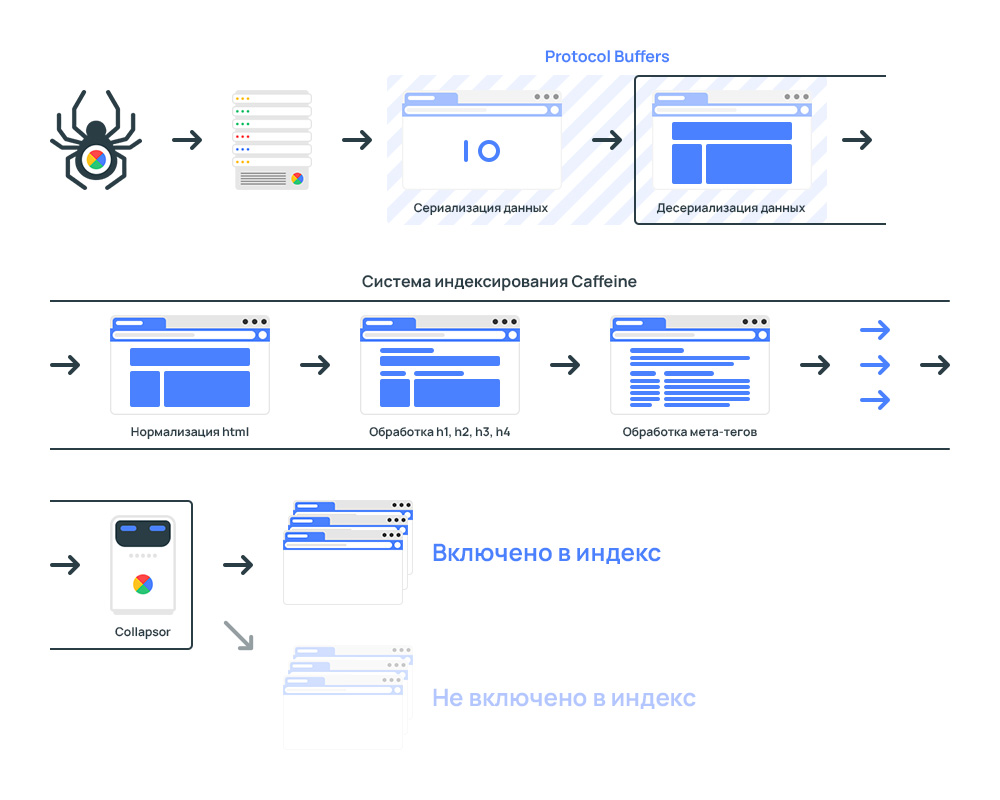

Весь процесс системы индексирования:

Сначала происходит выгрузка данных, которые собрал поисковый краулер Googlebot.

Для скорости обработки данные передаются в бинарном виде, то бишь применяется процесс перевода структуры данных в последовательность байтов.

Для обработки данных применяется Protocol Buffers.

Protocol Buffers — протокол сериализации (передачи) структурированных данных, предложенный Google как эффективная бинарная альтернатива текстовому формату XML

После получение данных система индексации конвертирует данные в специальный формат, который способны анализировать роботы.

Страница передается в лексер. Предназначение лексера в поиске и исправлении ошибок в коде страницы.

Часто на сайтах встречаются ошибки в коде. Провести анализ контента со страниц с ошибками нет возможности технически.

С целью устранения ошибок код анализируются через HTML-лексер и автоматически исправляются.

Ошибки в верстке страницы напрямую никак не влияют на ранжирование.

Пример лексера — W3C HTML Validator.

Далее происходит нормализация данных. Страницы разбиваются на фрагменты. Например:

- Meta tags

- Title

- H1, h2, h3, h4, h5

- Прочее

На последнем этапе включается система Collapsor.

Google Collapsor в системе индексации сайтов

Collapsor является подсистемой в системе индексации.

Collapsor определяет куда переместить страницу. Варианты:

- Индекс проиндексированных страниц, но бесполезных;

- Индекс обслуживания или Serving Index.

Именно Коллапсер присваивает страницам статус soft 404.

Коллапсер фильтрует индекс от бесполезных страниц: товар отсутствует, дубли, технические страницы и прочее.

Как обнаруживаются страницы дубли? Через анализ контрольной суммы checksum для каждой страницы, который основан на словах на странице. В результате, если есть две страницы с одинаковой контрольной суммой, то анализатор расценивает как дубли.

Индексация сайта гарантирует только обработку страниц. Попадание страниц в поисковую выдачу зависит от оценки страниц Google Коллапсером.

На основе Serving Index формируются результаты поисковой выдачи.

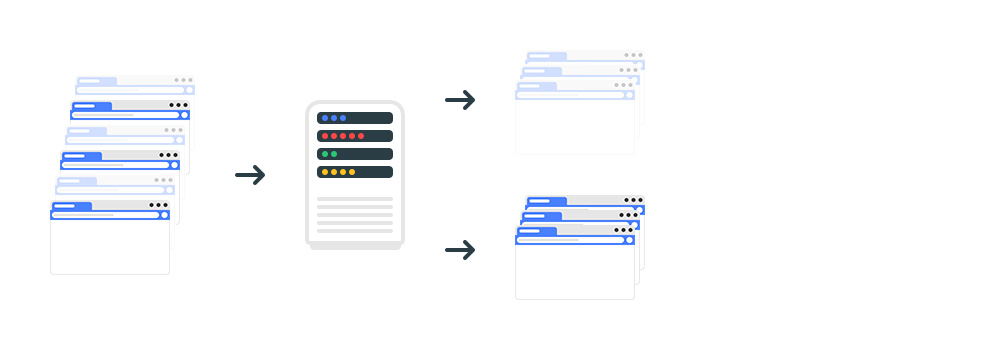

Google Serving Index — Индекс обслуживания

Индекс обслуживания или Serving Index — основной индекс поисковой системы состоящий из страниц, которые участвуют в ранжировании.

Находится в отдельных дата-центрах, откуда пользователи получают результаты поиска.

Документ попадает в Serving Index если:

- Код ответа — 200;

- Нет запрета к индексации;

- Collapsor пропустил страницу в индекс.

Поисковая система обрабатывает коды ответа так:

- 200. Роботу надо обойти страницу;

- 3XX. Роботу надо обойти страницу, которая открывается по редиректу.

- 4XX и 5XX. Страница с таким кодом не должна участвовать в поиске. Если до момента обращения робота страницы была размещена в поисковой выдаче, то будет удалена из индекса.

Как проверить наличие страниц в индексе? Разберемся на примере сайта indexoid.com.

Проверка индексации сайта в Яндекс с учетом всех поддоменов сайта:

site:indexoid.com

Проверка индексации в Яндекс по разделу:

url:chrome.google.com/*

Проверка индексации сайта в системе Google с учетом всех поддоменов сайта:

site:wixfy.com

Проверка индексации по разделу:

url:chrome.google.com/*

С учетом вхождений в заголовки:

site:ru.megaindex.com intitle:yandex

Проверка индексации по разделу:

inurl:chrome.google.com/*

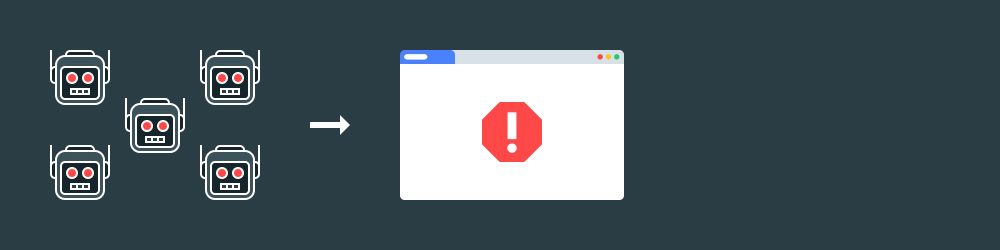

Если страницы перестали открываться, то такие страницы подлежат удалению из индекса.

Если сайт отдает код ошибки, то страницы удаляются из индекса.

Уязвимость могут эксплуатировать конкуренты по выдаче.

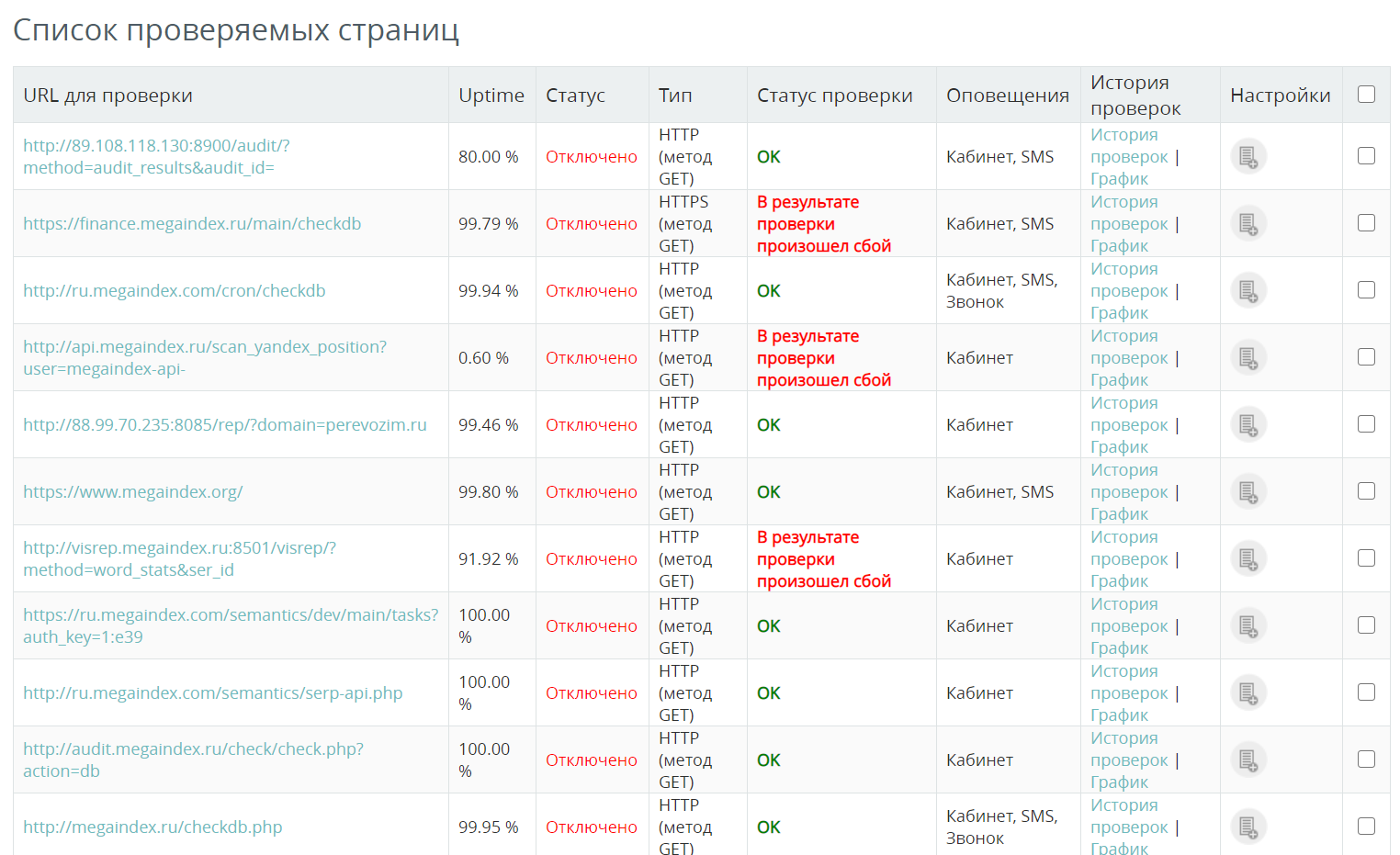

Как проверить доступность сайта? К примеру, можно использовать сервис от MegaIndex. Стоимость 1 проверки составляет 0.01 рублей. Если сервер сайта перестанет работать, система уведомит об инциденте удобным способом.

Ссылка на сервис — Проверка доступности сайта.

Пример отчета:

Вопросы и ответы

От чего зависит количество страниц подлежащих индексации?

Максимальное количество страниц, подлежащих индексации при очередном обходе сайта роботом определяет метрика под названием краулинговый бюджет.

Значение рассчитывает планировщик сканирования.

Подробности раскрыты в материале — Краулинговый бюджет сайта — что это и как оптимизировать?

Как изменяются в подходы по оптимизации индекса?

Подходы к оптимизации индекса сайта действительно изменяются. К примеру, если раньше наличие большого объема страниц в поисковой выдаче сказывалось положительно на продвижении, то теперь ситуация обстоит иначе.

Большое количество страниц в индексе позволяло создавать на сайте значимый ссылочный статический вес. Сигнал передавался через ссылки на важные внутренние страницы. В результате ранжирование важных страниц улучшалось.

Но алгоритмы поисковых систем были улучшены. Тактика перестала быть эффективной. Большое количество страниц на сайте имеет смысл только в случае, если страницы способны приносить трафик.

Выводы

Задача по улучшению индексация сайта требует внимания, поскольку влияет на позиции сайта в поисковой выдаче.

Через сигналы Web Vitals на ранжирование могут влиять даже страницы, которые закрыты в robots.txt.

Открытыми к индексации должны быть такие страницы:

- Страницы по которым планируется привлечение трафика из поисковой выдачи;

- Страницы сайта, важные для E-A-T.

Страницы сайта могут быть проиндексированы, но проигнорированы при включении в индекс обслуживания.

Приведенная информация является достоверной и подтвержденной из официальных источников.

В других поисковых системах процесс индексации схожий.

Если интересно узнать как найти на сайте бесполезные страницы и удалить страницы из индекса поисковой системы, напишите в комментариях.

Если остались вопросы по теме, напишите в комментариях.

Обсуждение

Тезисы актуальны для любого года.